머신러닝과 딥러닝으로 처음부터 공부해보고 싶어서 신청한 혼공학습단 14기

밑바닥부터 초심자 느낌으로 꼼꼼히 공부해보고 싶었는데,

혼공학습단 14기 활동에 참여하려면 "혼자 공부하는 머신러닝 + 딥러닝" 책이 필요했다.

[IT 서적] AI를 독학하는 가장 쉬운 방법 '혼자 공부하는 머신러닝 + 딥러닝'

요즘 인기가 많은 인공지능의 대표적인 기술, 머신러닝과 딥러닝 시중에 인공지능 관련 서적은 많지만 어떤...

blog.naver.com

하지만 운이 좋게도 '나는 리뷰어다' 활동을 통해서 이미 책을 받은 적이 있어서 마음가짐만 준비한다면 참여하는 데에 문제가 없었다.

정확히 두달 전이었던 2025년 6월 25일

문득 메일을 받았는데 내 바램과 목표를 알아주었던 것인지 혼공학습단 14기에 선정되었다.

혼공머신으로 참여하였는데, 1주차부터 6주차까지 매주 정해진 진도를 공부하고 기본 숙제와 추가 숙제를 수행하는 것이 메인 미션이었다.

이미 한번 공부해본 경험이 있었기에, 숙제 내용을 보고 꾸준히 한다면 부담감 없이 숙제를 할 수 있겠다는 자신감이 있었다.

사람마다 코딩 공부의 방식의 차이는 있겠지만, 이론과 실습이 병행되어야 제대로된 공부를 했다고 생각한다.

혼공학습단의 장점은 블로그 포스팅에 정리하면서 혼자서 이해한 내용을 설명할 수 있는 기회를 가지게 된다.

또한 예제 코드를 단순히 따라 치지 않고, 이해한 내용을 바탕으로 직접 코드 구현을 해볼 수 있었던 것도 정말 유익했다고 생각한다.

특히 평소에 로컬 환경에서 구현해서 사용하던 사람이라, 코랩을 써보니 라이브러리 문제가 없는 것이 너무 편하고 좋았다.

혼공학습단의 또 다른 장점은 매주 진행한 숙제를 바탕으로 혼공족장님께서 우수 혼공족에게 포상을 준다는 것이다.

심지어 4주차를 완료하고 나면, 고생했다는 의미로 과제 완료자에게 깜짝 선물까지 챙겨주시는 세심함에 공부하고 싶은 욕구가 더 생겼다.

열심히 하다보니 5주차에는 우수 혼공족으로 선정되었는데, 혼공학습단 덕분에 맛있는 간식을 더 먹을 수 있었다.

혼자 공부하면서 지식을 쌓는데 간식도 주고, 혼공족장의 격려 메세지까지 받을 수 있는 건 흔한 기회가 아니라 생각했다.

혼공학습단을 통해서 진행한 진도 이외에 남은 부분이 많지 않아서 8월 중에 한권을 마무리 지으려고 한다.

6주라는 기간동안 책 한 권을 꾸준하게 본다는 것은 의지가 필요한 일처럼 보이지만, 생각보다 어려운 일은 아니었다.

코딩 공부를 꾸준하게 하면서 응원 메세지와 간식까지 받으면서 재밌게 공부하고 싶다면, 혼공학습단 참여를 강력하게 추천하고 싶다.

사실 혼공학습단 15기도 모집 예정이라고 하는데, 다음 기수에도 꼭 신청하여 다른 책을 완독할 예정이다.

'Study Group > 혼공학습단 14기' 카테고리의 다른 글

| [혼공학습단 14기_혼공머신 6주차] 인공 신경망 (Artificial Neural Network) (2) | 2025.08.17 |

|---|---|

| [혼공학습단 14기_혼공머신 5주차] K-평균 알고리즘 (0) | 2025.08.10 |

| [혼공학습단 14기_혼공머신 4주차] 교차 검증 (Cross Validation) (3) | 2025.08.03 |

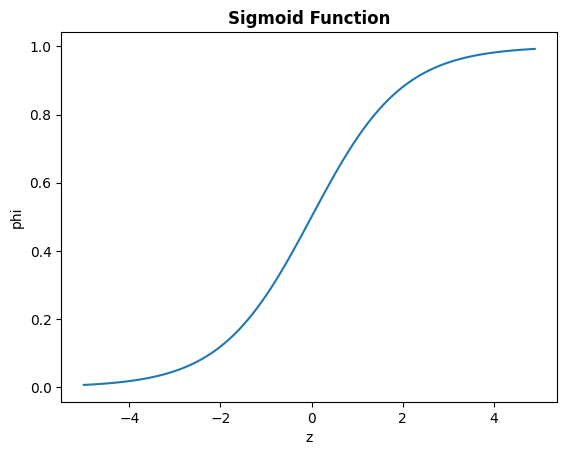

| [혼공학습단 14기_혼공머신 3주차] 로지스틱 회귀 (Logistic Regression) (0) | 2025.07.24 |

| [혼공학습단 14기_혼공머신 2주차] k-최근접 이웃 회귀 모델의 변화 (1) | 2025.07.13 |